DEEP SEEK 如何在本地部署(Ollama + ChatBox)+ 私有知识库(cherry studio)

1 软硬件需求 ( 我的显卡 AMD VEGA 56 )

1.1 硬件需求 DeepSeek R1 本地部署的硬件需求如下:

基本推荐配置:

2.1 Ollama 的下载

2.2 Ollama 的安装

2.3 Ollama 的运行

deepseek - r1 模型安装

3.1 Ollma 安装 deepseek - r1 模型

1.5b 的命令为:“

ollama run deepseek-r1:1.5b

7b 的命令为:“

ollama run deepseek-r1:7b

14b 的命令为:“

ollama run deepseek-r1:14b

ollama run deepseek-r1:32b

ollama run deepseek-r1:70b

本教程选择选择 7b 模型,在命令行窗口运行安装命令 “ollama run deepseek - r1:7b”,程序会自动下载和安装运行。

安装完成后显示 “success”,表明安装成功。

3.2 使用 deepseek - r1 模型

在命令行窗口运行命令 “ollama run deepseek - r1:7b”,就可以在提示行输入,与 deepseek - r1 进行聊天。

输入 “/?”,可以获得帮助。

3.3 修改ollama安装地址。

打开系统属性:右键点击Windows桌面上的“此电脑”或“计算机”图标,选择“属性”以打开系统属性窗口。

进入环境变量设置:在系统属性窗口中,点击左侧的“高级系统设置”按钮。在弹出的“系统属性”窗口中,切换到“高级”选项卡,然后点击“环境变量”按钮。

新建或修改环境变量:在“环境变量”窗口中,可以在“系统变量”或“用户变量”部分找到或新建一个名为OLLAMA_MODELS的环境变量。如果已存在该变量,则直接选中并点击“编辑”按钮;如果不存在,则点击“新建”按钮来创建一个新的环境变量。

设置新的存储路径:在“编辑环境变量”或“新建环境变量”窗口中,输入变量名OLLAMA_MODELS,并在“变量值”文本框中输入希望保存模型文件的新目录路径。例如,如果希望将模型文件保存在D盘的OllamaModels目录下,则输入

D:\OllamaModels。重启Ollama:设置完环境变量后,需要重启Ollama以应用更改。可以通过任务管理器结束Ollama的进程,然后重新运行Ollama来实现重启。

3.4 删除模型

打开终端或命令行界面:首先,你需要打开你的终端或命令行界面。

导航到存储模型的目录:确保你的当前工作目录是存储模型的文件夹。

使用命令删除模型:输入命令

ollama rm <model_name>,其中<model_name>是你要删除的模型的名称。确认删除操作,根据提示输入确认信息,然后等待删除完成。

ollama rmdeepseek - r1:7b备份重要数据:在删除模型之前,请确保你已经备份好了需要保留的数据。删除模型是一个不可逆的操作,一旦删除将无法恢复。

版本差异:具体的命令和操作可能会因为OLLAMA的版本而有所不同,建议参考OLLAMA的官方文档或者使用

ollama --help命令获取更多帮助信息。

4.1 使用CHAT_BOX 安装

申请API:目前Deep Seek 正在遭受国外黑客攻击,所以推荐使用 硅基流动 的API,价格跟官方一致。

点击https://cloud.siliconflow.cn/i/PQjf5Pqp

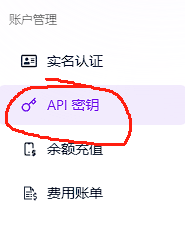

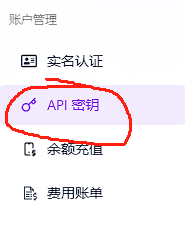

申请账户登录后,再左侧菜单栏找到API 秘钥。

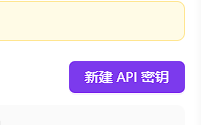

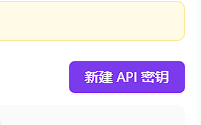

右上角点击生成

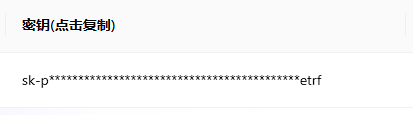

点击秘钥进行复制:

4.2 使用CHATBOX

登录官方页面:https://chatboxai.app/zh

点击运行网页版(使用桌面版也一样)

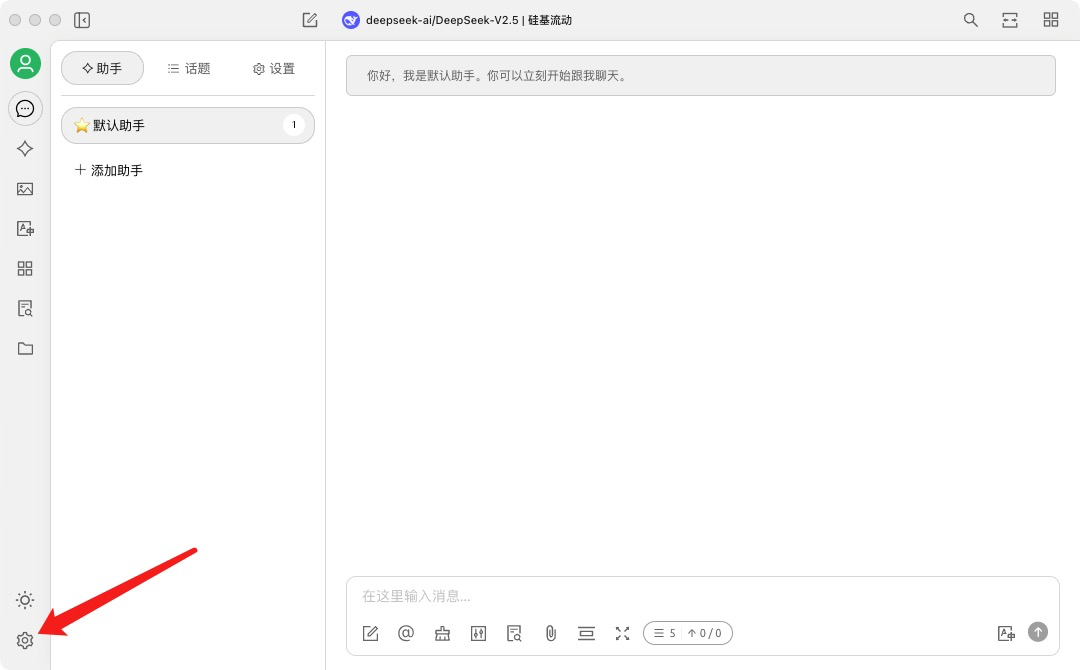

点击左下角 setting。

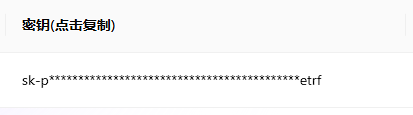

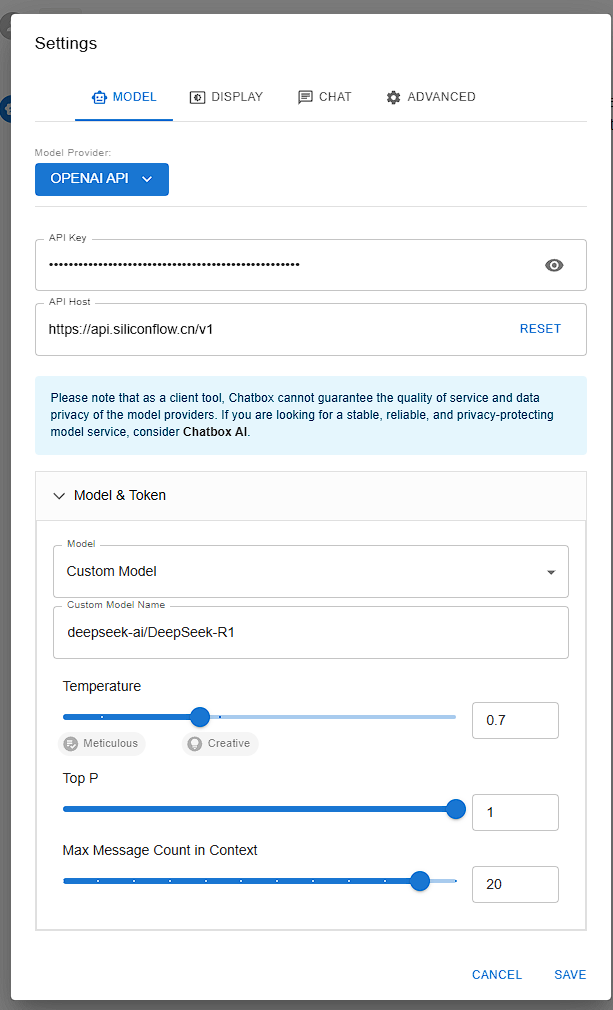

如图所示: Model Provider :OPENAI API

拉倒最下面,选择 custom model (或者 自定义模型)

开始聊天。点击左下角:new chat 。 进行聊天即可。

4.3 CHAT汉化

左下角 Settings

选择 Display

第一个 选择中文。

5 设置DeepSeek R1部署和本地私有知识库

5.1 安装cherry studio

通过Chat_box 安装的朋友们可以通过设置本地知识库的方式,实现个人智能体助手

下载 cherry_studio(功能和chatbox一致,但更加强大,可以代替chatbox)

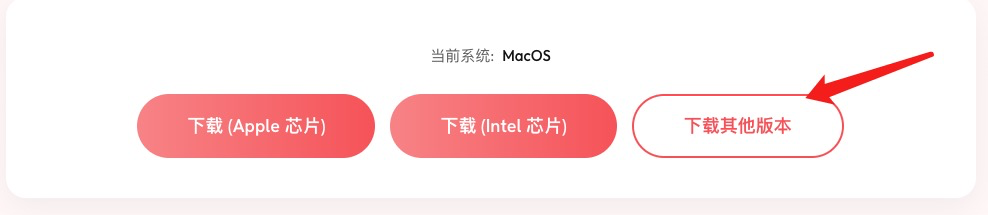

下载地址:https://cherry-ai.com/download。选择对应的系统进行下载。

如果需要选择其他系统:

本地安装

申请API:目前Deep Seek 正在遭受国外黑客攻击,所以推荐使用 硅基流动 的API,价格跟官方一致。

点击https://cloud.siliconflow.cn/i/PQjf5Pqp

申请账户登录后,再左侧菜单栏找到API 秘钥。

右上角点击生成

点击秘钥进行复制:

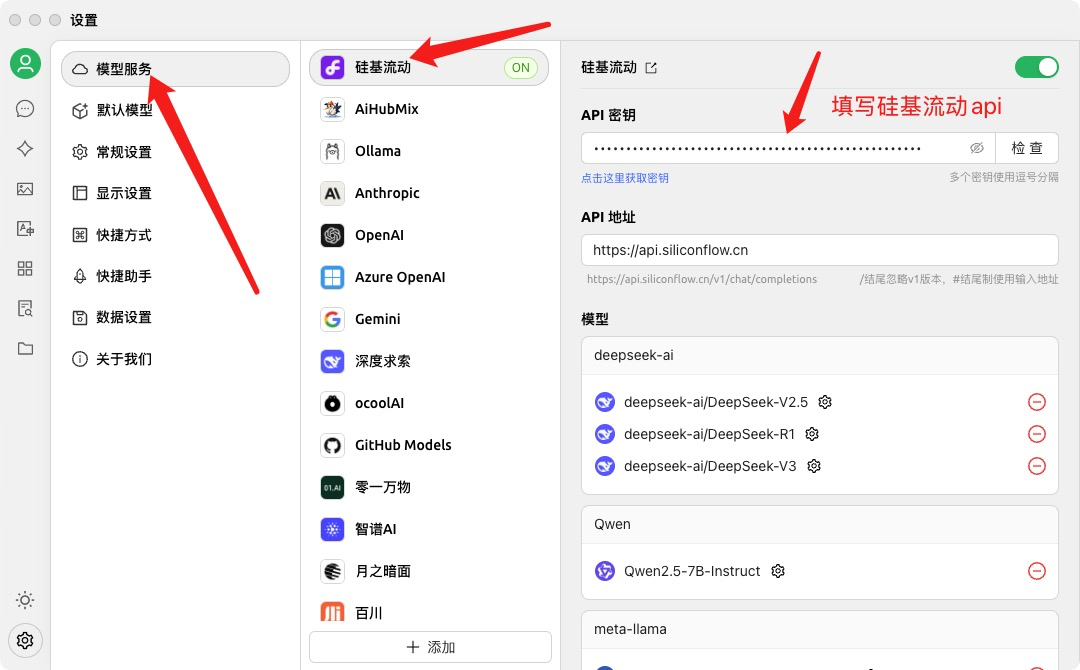

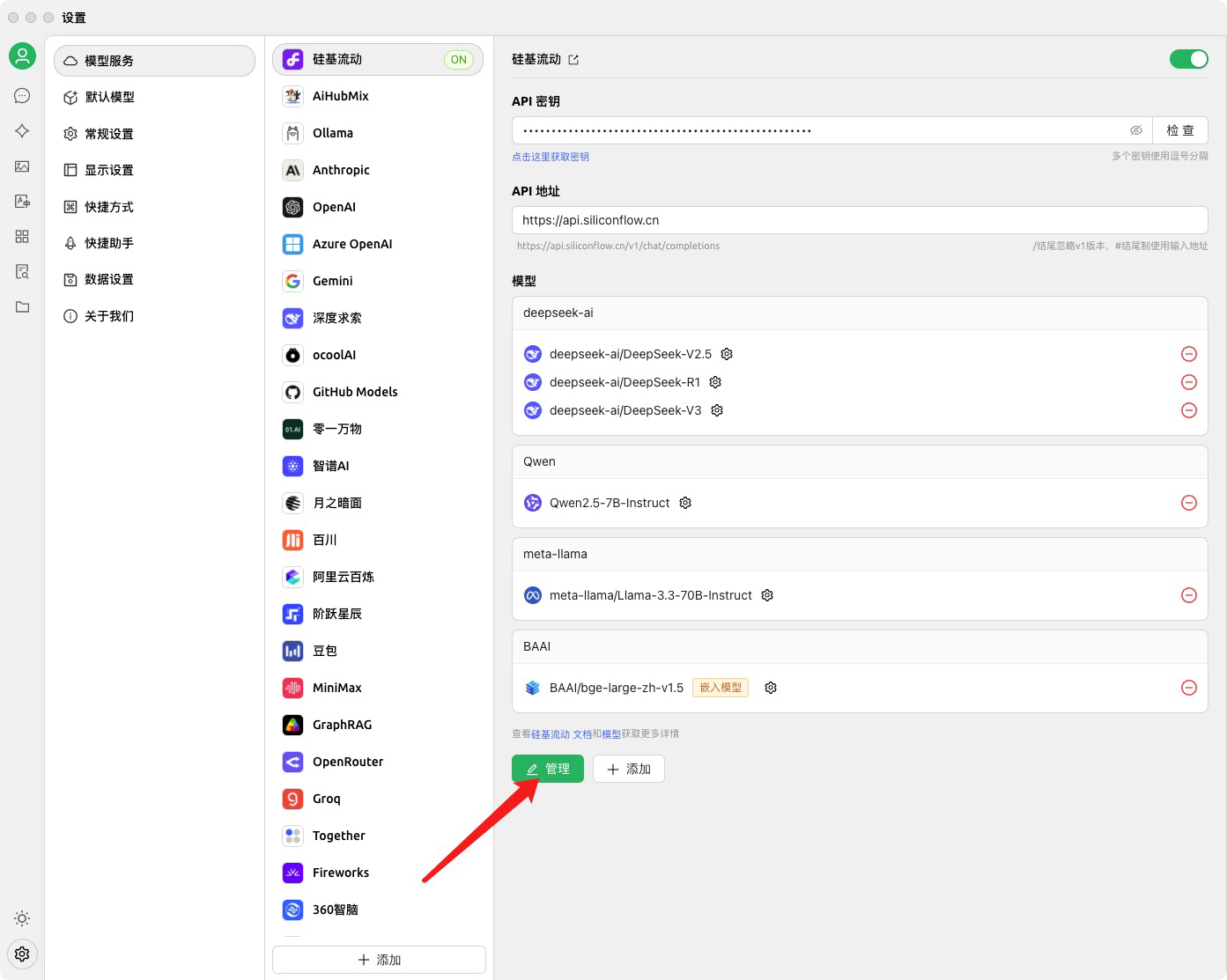

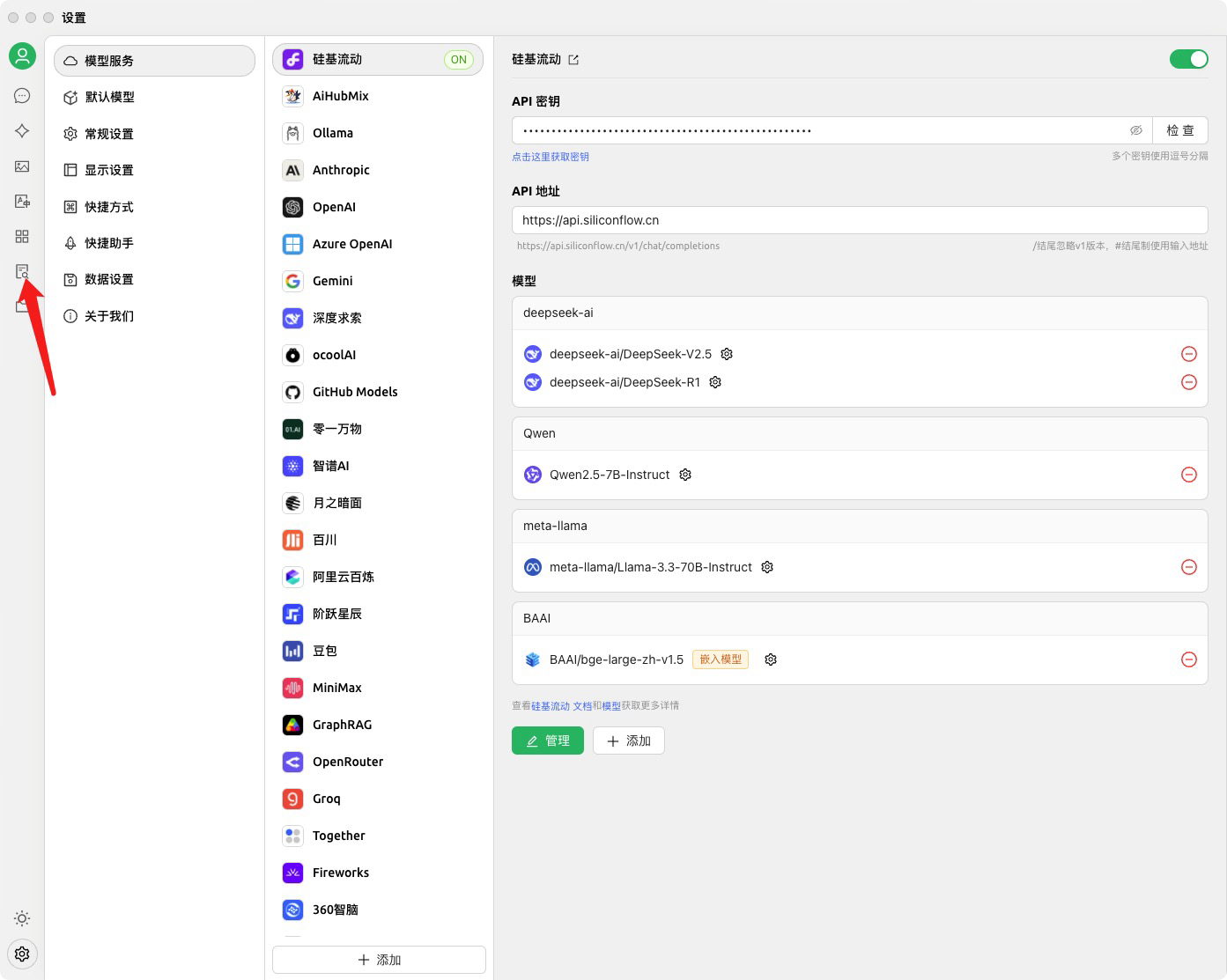

5.2 设置API接口(获取API的方法,在4.1章)

打开设置界面:

选择硅基服务,并填写API

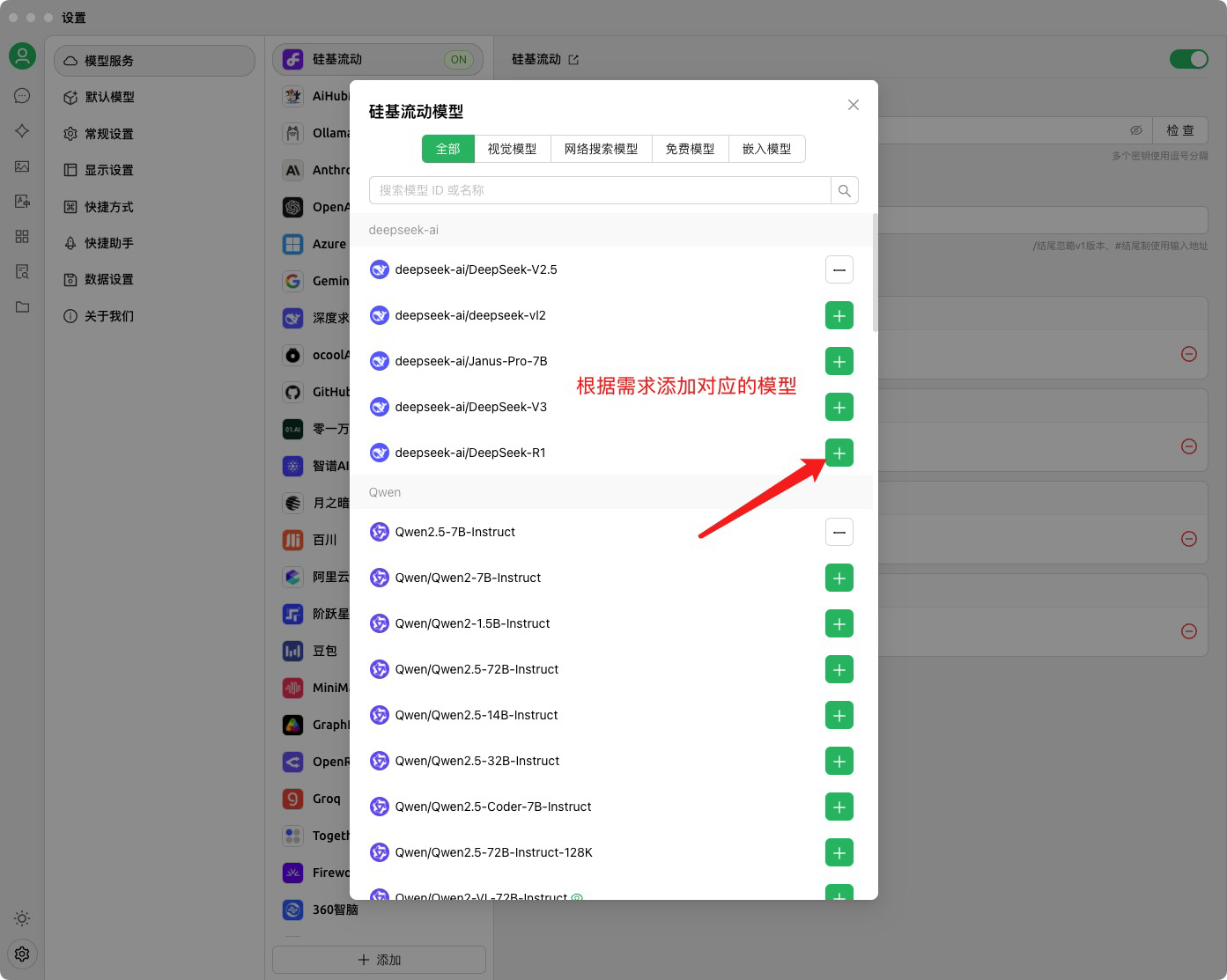

添加模型

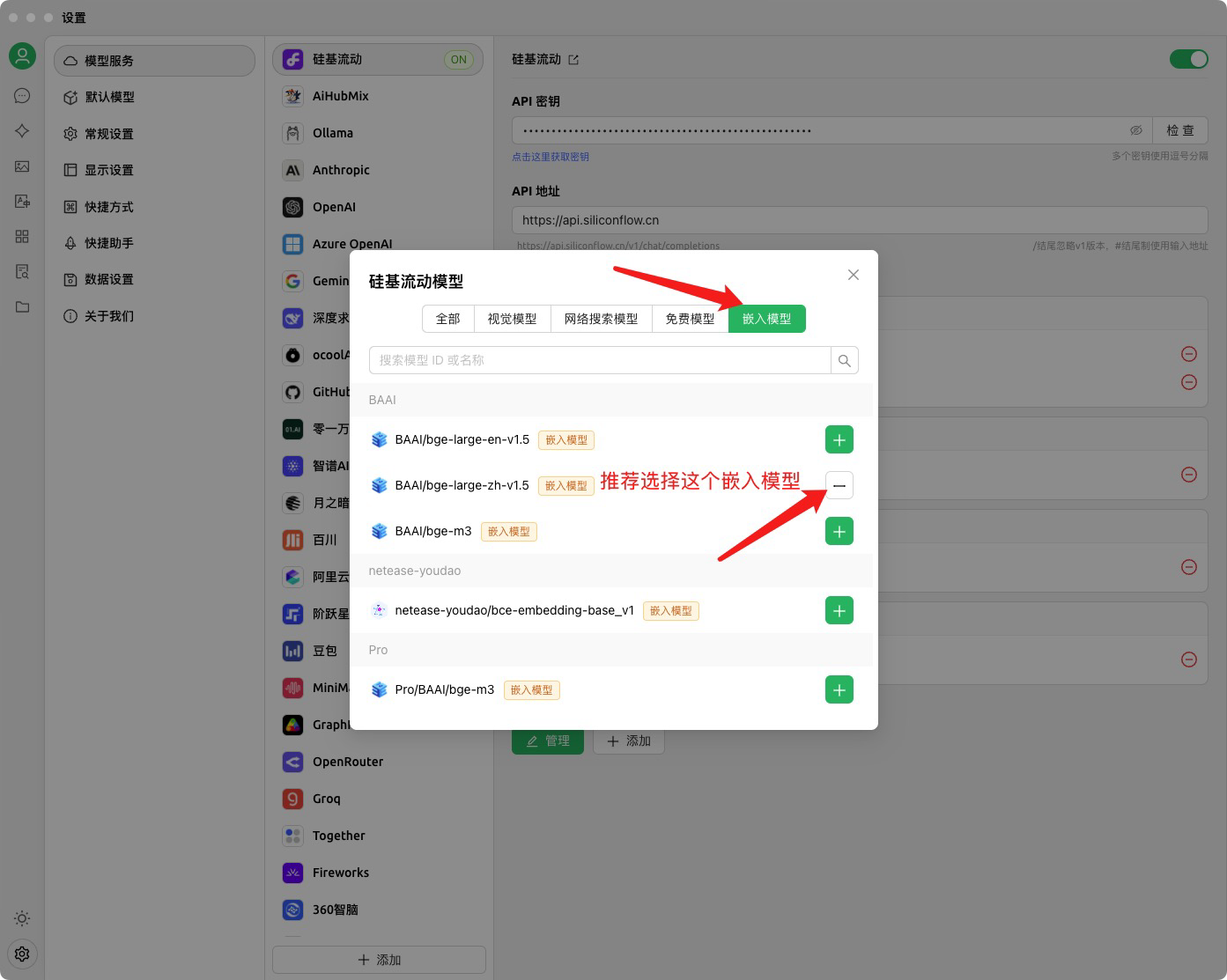

添加嵌入模型

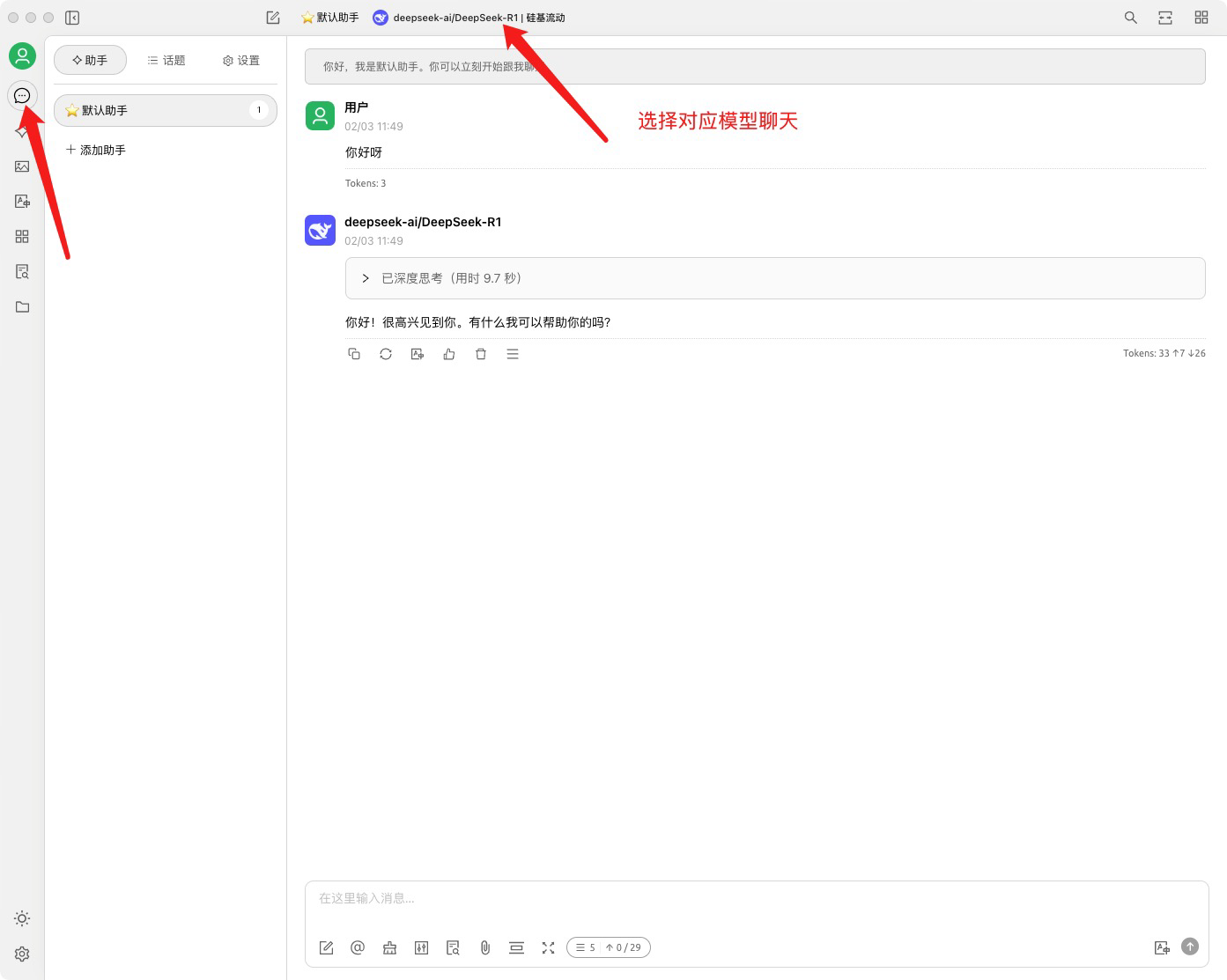

聊天测试是否安装成功

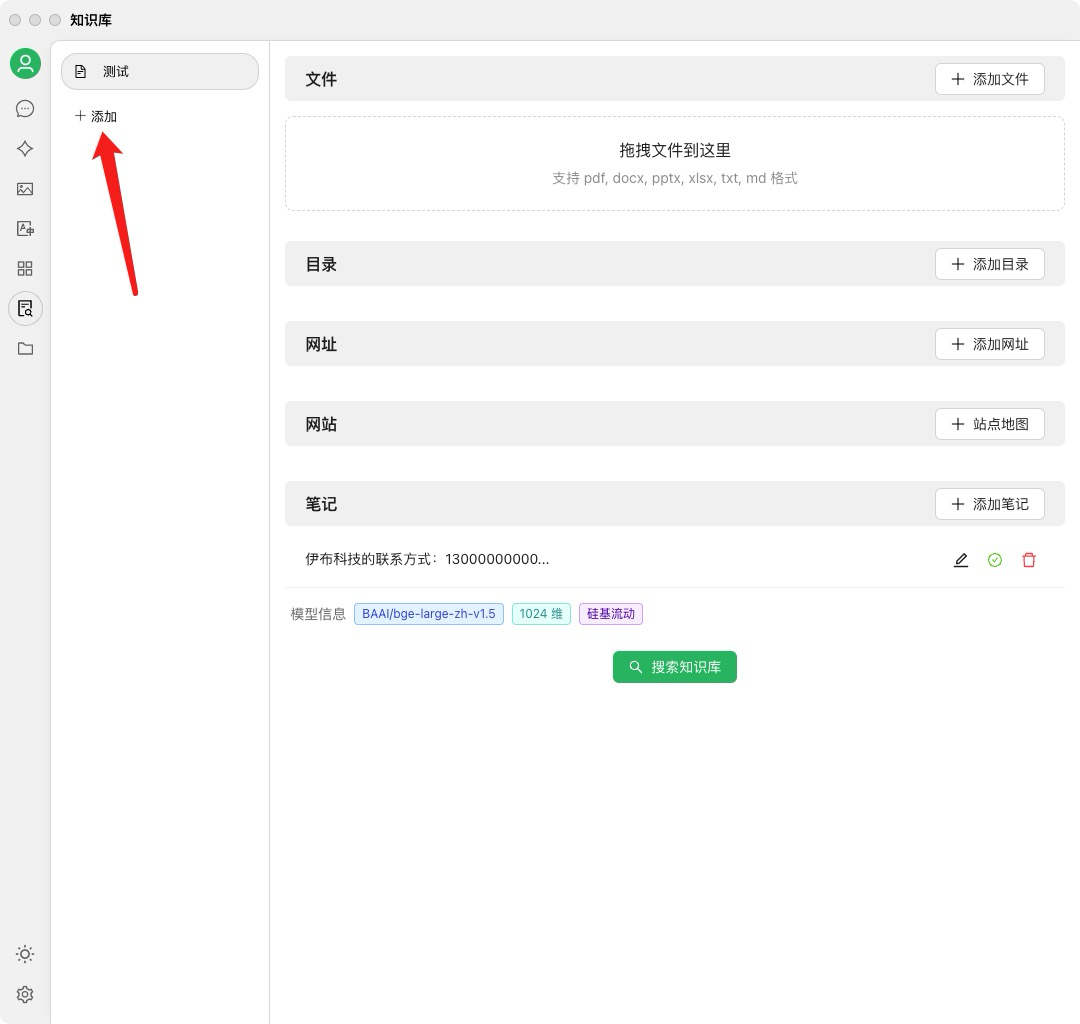

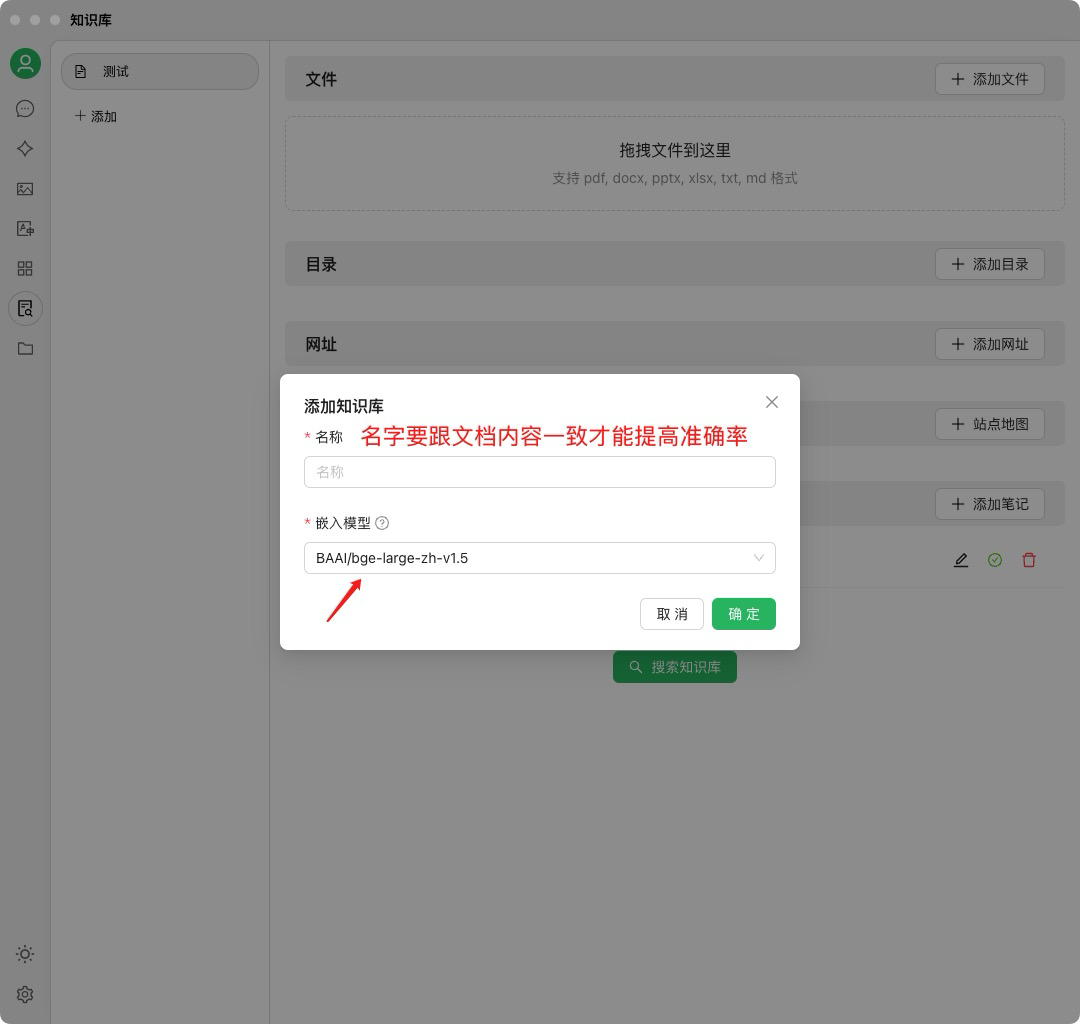

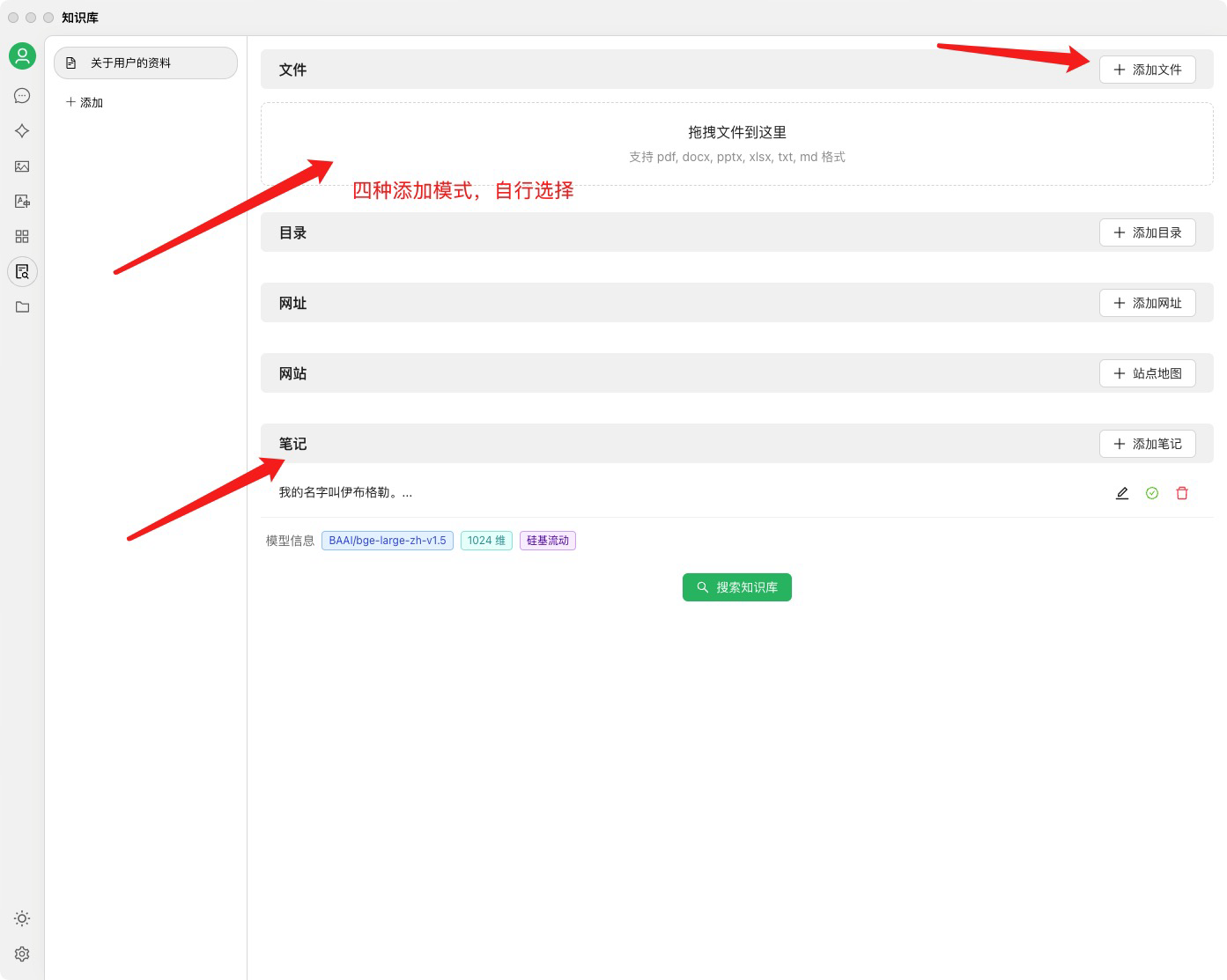

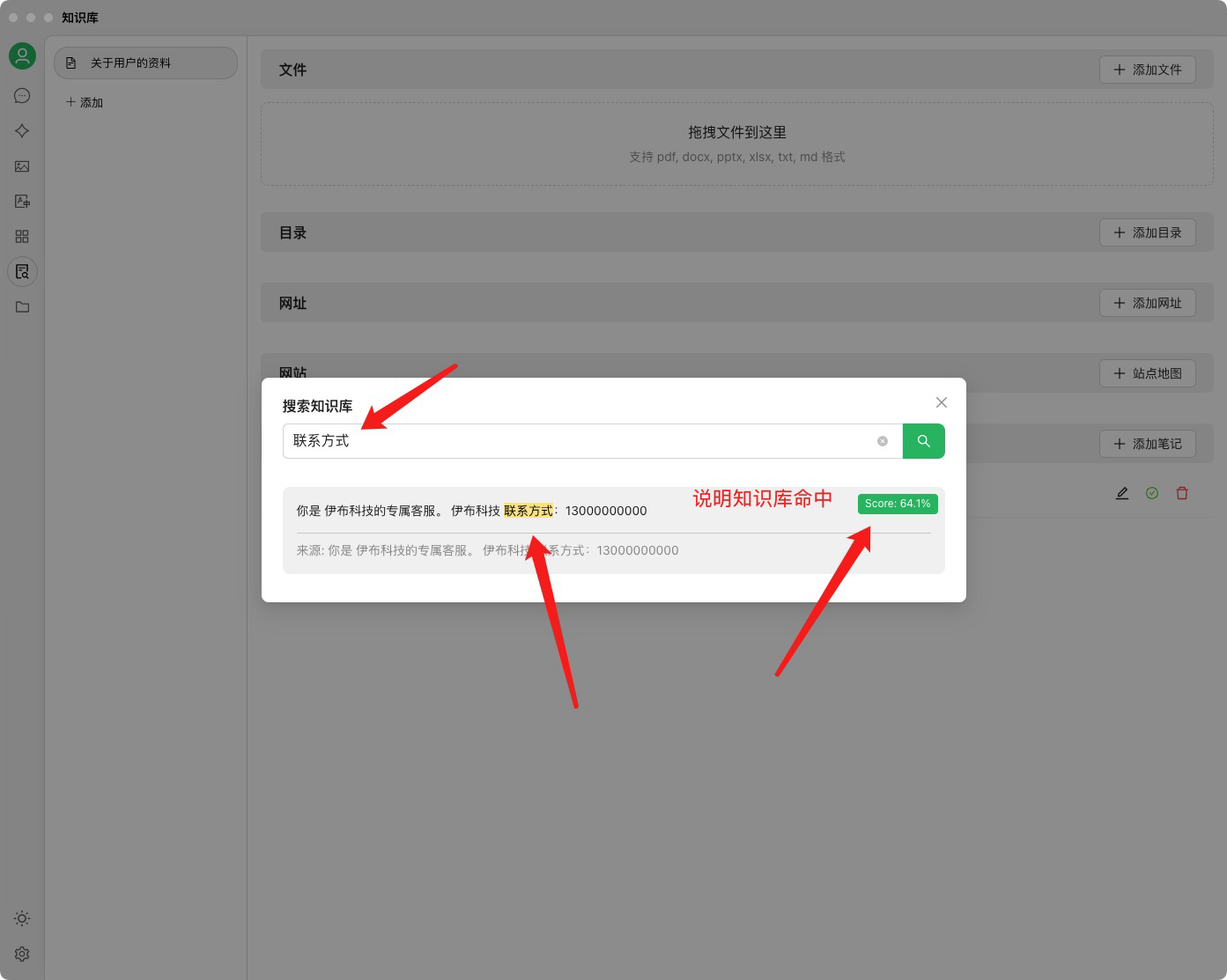

添加知识库

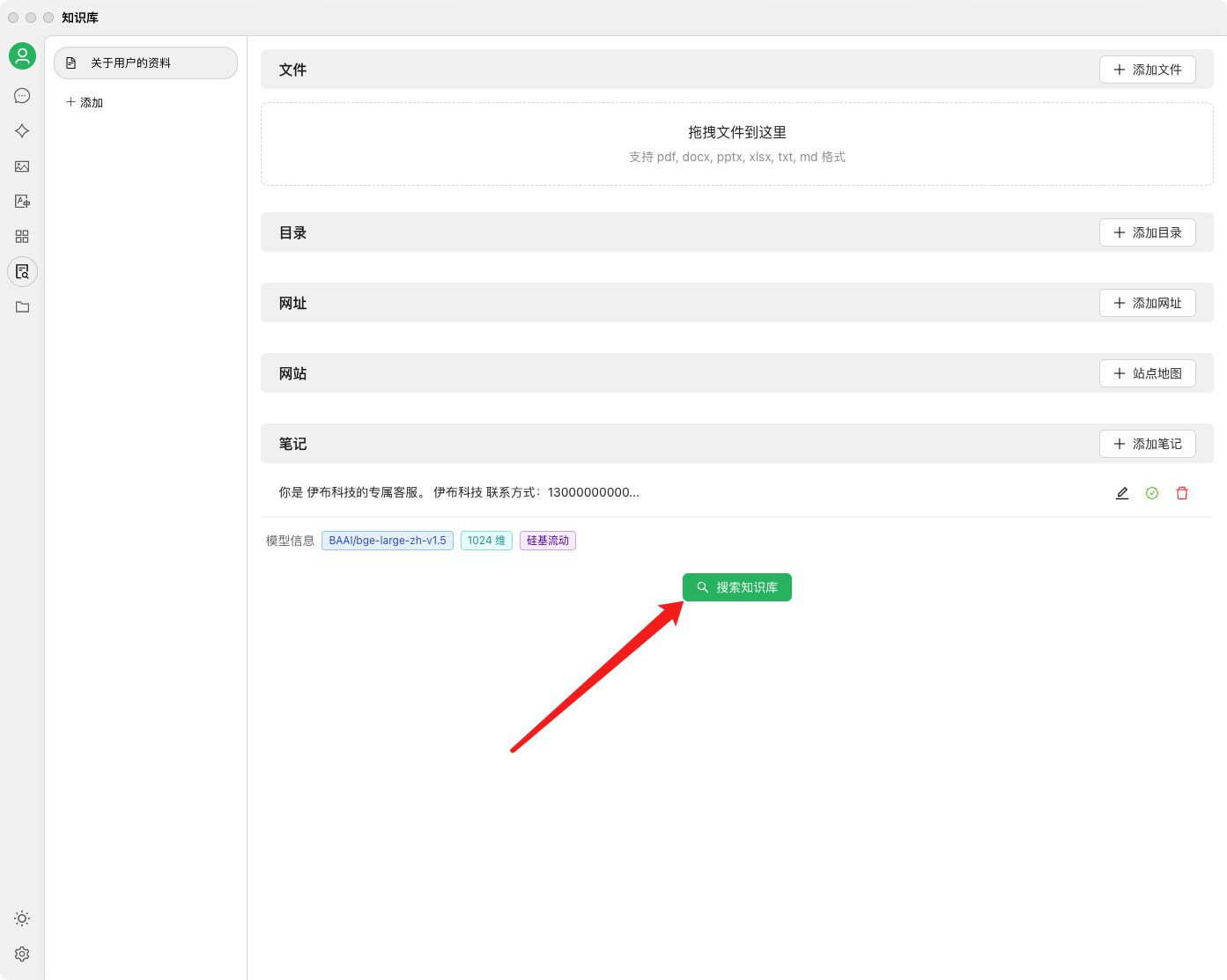

确认知识库安装成功,并尝试搜索

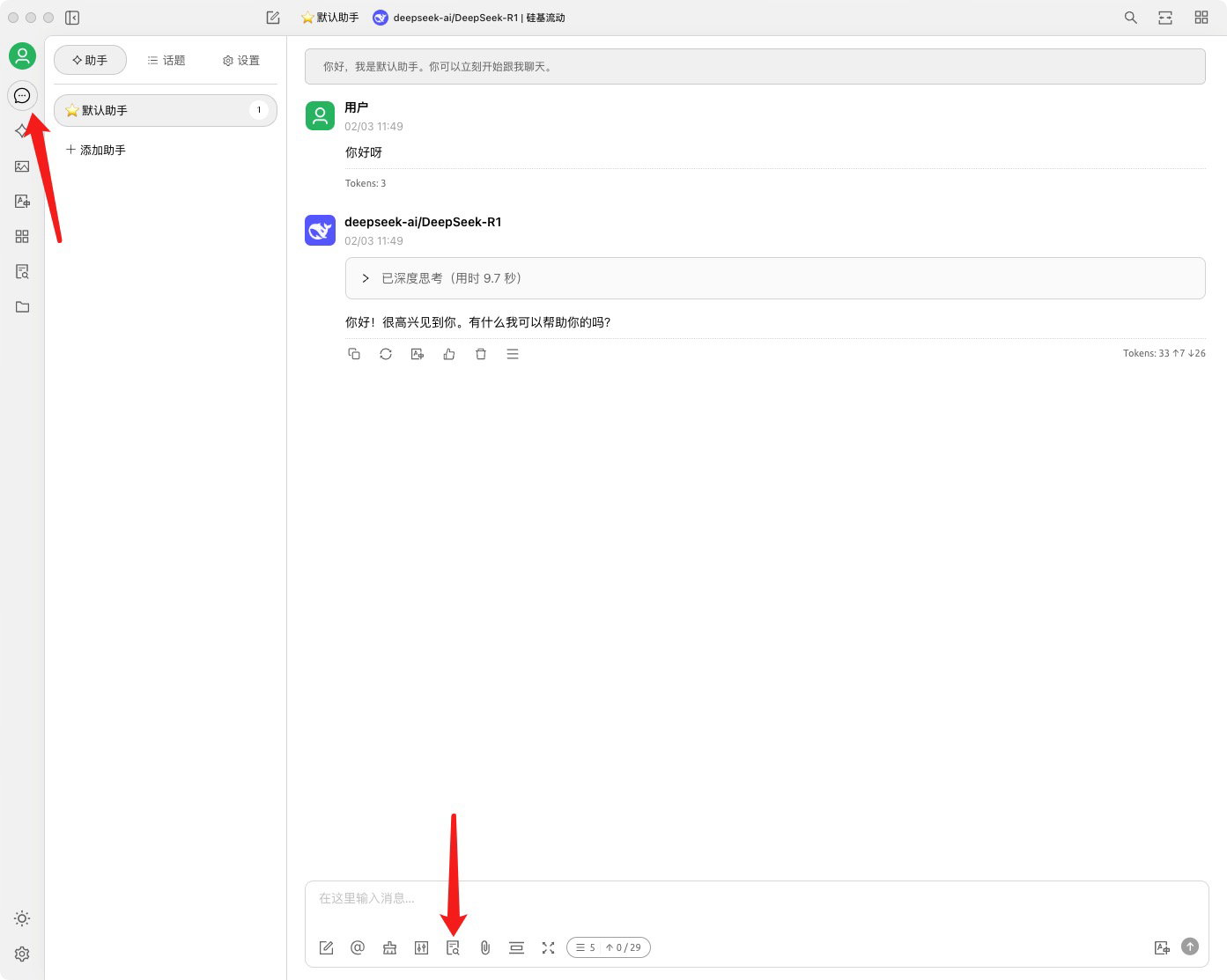

聊天中设置知识库

设置完成。